CPU如何成為閱片又快又準的加速器?

導語

CPU可以加速醫學影像推理過程,且性價比更高,成為閱片又快又準的加速器。

21世紀,最貴的除了人才還有什么?那就是算力!算力!還是算力!隨著數字經濟的蓬勃發展,各行各業面臨生產力的短缺。為了解決這一現狀,越來越多的行業轉向了自動化。在這個過程中,各種人工智能的應用案例屢見不鮮,人工智能不再只是停留在論文里,而是已經有了豐富的商業落地案例。其中有兩個案例讓人印象很深刻。

算力在制造業的落地

第一個案例就是算力發展在制造業的體現。

不論是手機還是電腦,各類電子設備都有一個非常重要的人機交互元件:屏幕。屏幕相關的產品線涵蓋了TF T-LCD、AMOLED等一系列先進顯示和傳感器件,這些產品無一不對質量有著嚴苛的要求。隨著產業規模的不斷擴大,基于人工的缺陷檢測和不良根因分析,在效率上已經難以滿足進一步提升產能和品控的要求。現在基于深度學習來協助實現缺陷定位和缺陷檢測等功能的工業視覺平臺,能夠借助大數據平臺和AI算法,智能分析和快速定位不良根因。

英特爾? 至強? 可擴展平臺在邊緣加速 AI 缺陷檢測

「缺陷檢測」是屏幕、傳感器等精密器件生產中的關鍵環節,之前一直依靠人工檢測,然而人工檢測存在很多不足,一般主要包括人才的培養費時費力,其次是檢測準確率相對較低,隨著工藝飛速發展,涉及的缺陷類型越來越多,且許多已經很難用肉眼發現。

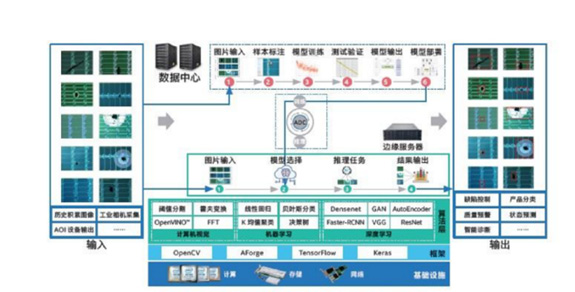

曾經為了解決這個問題,企業需要培訓和安排大量檢測工程師來確保產品質量。但現在可以借助英特爾邊緣計算的能力,通過研發基于深度學習方法的自動化缺陷分類 (Automated Defect Classification, ADC) 系統,來提升缺陷檢測效率。在新的AI缺陷檢測系統中,歷史積累的圖像以及由自動光學檢測 (Automated Optical Inspection,AOI) 等設備采集的圖像,都會由邊緣服務器預處理后匯入數據中心,并使用ResNet、Faster-RCNN等圖像檢測和分類算法進行訓練,輸出的模型會被部署到邊緣服務器中。新AI缺陷檢測系統上線部署后,可大幅提升檢測準確率并降低人力成本,真正實現降本增效。

算力在醫學輔助診斷領域的落地

得益于算法的進化、算力的提升,AI輔助診斷得到了廣泛的應用。然而,AI輔助診斷應用由于對IT基礎設施有著較高要求,在實際落地中面臨著硬件成本、軟件優化和方案整合等挑戰。

AI應用于醫學診斷,主要還是通過利用醫學影像進行輔助診斷。近幾年, CT的臨床診療應用直接凸現了影像檢查的重要性。通過英特爾OpenVINO?工具套件可加速閱片效率。該工具套件基于卷積神經網絡 (CNN) 而設計,支持從邊緣到云的深度學習推理,可以在所有英特爾平臺上部署并加速神經網絡模型,顯著提高圖像推理速度。由此可快速構建、優化和積累高質量的樣本數據和認知模型,為醫療專業人員與AI技術專業人員協作搭建創新的平臺,全面優化模型推理效率。利用定制的DNN拓撲來識別影像、通過支持多種病理切片數據的接入來實現病理圖像的數字化診斷與分享,這些能力讓病理診斷業務擁有遠程會診、集中診斷等更多延展空間,為醫生閱片提供參考。

可見算力已經深入到生產生活的方方面面,可以預計的是,人類生活未來必然越來越離不開算力,而高性價比地獲取算力也將成為商業成功的重要部分。

英特爾? 至強? 可擴展處理器算力賦能,加速AI推理過程

提到AI的推理,大家的第一反應可能是需要強大的GPU。但實際上,經過多年的發展,CPU同樣可以加速推理過程,且性價比更高。像英特爾? 至強? 可擴展處理器,內置了人工智能計算和高級安全功能,依靠其強大算力可以極大提高AI推理效率,并兼顧成本與安全性。

為了在CPU上實現優秀的AI推理能力,英特爾從底層指令集的設計,到矩陣運算加速庫,再到神經網絡加速庫都進行了專門的優化。

CPU指令集是計算機能力的核心部分,英特爾? AVX-512指令集旨在提升單條指令的計算數量,從而提升CPU的矩陣運算效率。在加速訓練環節,英特爾? DL Boost 把對低精度數據格式的操作指令融入到了AVX-512指令集中,即AVX-512_VNNI(矢量神經網絡指令)和AVX-512_BF16(bfloat16),分別提供了對 INT8(主要用于量化推理)和BF16(兼顧推理和訓練)的支持。

了解了基本原理后,我們再來看使用CPU訓練模型的優勢就很明顯了:在只使用英特爾? 至強? 可擴展處理器的情況下,內存可以便捷地根據需要擴充,同時也可以根據任務和場景分配計算核心,這樣的靈活性是其它硬件很難具備的。

另外,在企業中部署AI模型,CPU服務器同樣常用。大多數AI實際要求的是并發量,對推理速度沒有特別高的要求;而且制造業或圖像行業的模型也不會太大,這種情況就很適合使用CPU作為計算設備。

在執行上線部署時,常見的推理引擎部署工具就有OpenVINO?(Open Visual Inference & Neural Network Optimization,開放視覺推理及神經網絡優化)。它是英特爾基于自身現有硬件平臺開發的工具套件,用于加快高性能計算機視覺和深度學習視覺的應用開發速度,具有專屬為CPU優化的特質。目前已廣泛應用在工業、零售、輔助診療等領域。

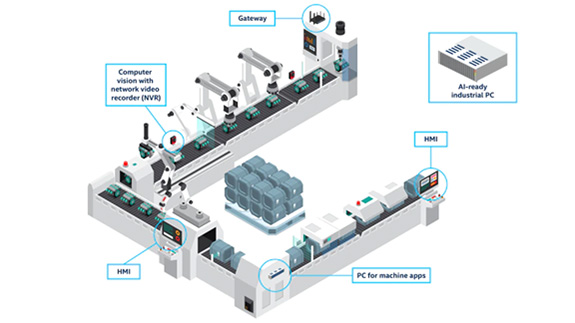

圖:在制造業中,至強可擴展處理器可作為邊緣計算設備,也可為多功能平臺提供基本計算能力,以支持各種AI場景與模型。

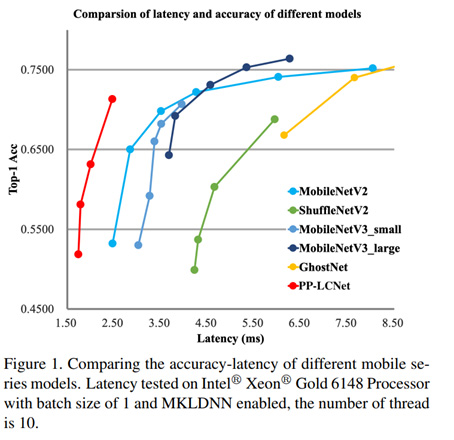

此外,學術界也有一個研究方向就是輕量級神經網絡,目標是使用較少的參數和較低的算力達到同樣性能與效果。例如百度提出的PP-LCNet,一個能夠在CPU上訓練的深度學習網絡模型,總結起來改進了4點:

1.使用H-Swish(替代傳統的 ReLU);從而避免了大量的指數運算。性能有了很大的提高,而推理時間幾乎沒有改變。

2.SE模塊放在最后一層,并使用大尺度卷積核;產生了更好的精度-速度平衡。

3.大尺度卷積核放在最后幾層;在網絡的尾端,用只有5×5卷積內核取代3×3卷積內核的影響,與所有層的網絡層都使用5×5卷積內核的網絡效果幾乎一樣。所以只在網絡尾端做了5×5卷積內核替換操作。也極大地減少了計算量。

4.在最后的global average pooling后增加更大尺寸的1x1卷積層。

有了這四個變化,在英特爾MKLDNN加持下的至強可擴展處理器實現了71.32%的top-1準確率和2.46ms的延遲,其準確率和速度都大大超過之前的網絡結構。

圖 PP-LCNet 輕量級CPU卷積神經網絡

隨著學術界研究的不斷深入以及工業界不斷的優化,用CPU訓練輕量級神經網絡將可能是一個性價比頗高的選項,CPU相比GPU減少了訓練數據在內存中的反復轉移,使得CPU訓練輕量級神經網絡更高效。重要的是訓練這些輕量神經網絡使用CPU就足夠了,而GPU顯得“殺雞焉用牛刀”,同時成本卻遠高于CPU。

隨著我國大力提倡推動云平臺的發展,結合英特爾邊緣計算帶來的優勢,利用5G、人工智能、高性能計算、大數據分析等新技術,探索更多應用場景,不僅推動制造行業的智能化轉型,還促進了醫療領域的信息共享和智能化發展。

點擊【此處】,了解更多英特爾至強產品組合

(本文由英特爾公司供稿)

首 頁

首 頁