安志萍:基于機器學習算法在中文文本分析中的應用

自然語言處理(NLP)是人工智能領域中的關鍵分支,專注于使計算機能夠理解、解釋和生成人類語言。在眾多NLP的子領域中,中文文本分析因其獨特的語言結構和應用需求,在技術發展和實際應用中占據了舉足輕重的地位。

在現代科技領域,中文文本分析的應用場景極為廣泛,其重要性體現在多個方面。例如,在搜索引擎中,中文文本分析技術是實現對大量中文內容進行有效索引和分類的關鍵,確保了用戶查詢的快速響應和信息的準確匹配。在智能問答系統中,中文文本分析技術使系統能夠深入解析用戶的詢問,并提供恰當的回答,增強了人機交互的自然性和準確性。此外,在輿情監測領域,中文文本分析技術通過對網絡文本的實時分析和評估,為及時發現和應對潛在的負面信息提供了技術支持。

為了實現這些功能,中文文本分析需要對語言的語法結構、語義內容以及情感傾向等層面進行深入的理解和處理。這不僅涉及到對語言本身的深刻洞察,也需要依賴先進的機器學習算法來提升處理的效率和準確性。機器學習算法為中文文本分析提供了強大的技術支持,使對復雜語言現象的建模和分析成為可能。

本文將重點探討機器學習算法在中文文本分析任務中的應用與大家進行交流,分析其主要功能,并評估其在具體實驗中的表現,旨在進一步推動中文文本分析技術在實際應用中提供參考。

一主要算法介紹

1.分詞算法

在中文文本中,一個有意義的詞匯單元通常由一個或多個漢字組成,這些漢字在語義上具有一定的關聯性。分詞算法是自然語言處理中的基本任務之一,是將連續的中文文本切分成一個個有意義的詞匯單元的過程,例如詞語、成語、短語等。常用的中文分詞算法包括基于字典的分詞、基于統計的分詞、基于機器學習的分詞等,這些算法各有優缺點,需要根據具體應用場景進行合適的選擇。基于字典的分詞算法主要依靠事先構建的規則或分詞詞典,將文本切分成對應的詞匯單元;基于統計的分詞算法則通過統計學方法,從文本中統計出現頻率較高的詞匯單元,建立詞頻模型和詞性標注模型,然后利用這些模型對新的文本再進行分詞;基于機器學習的分詞算法則是利用深度神經網絡等機器學習技術,通過大量的訓練數據,將分詞問題轉化為一個序列標注問題,從而學習出更加準確的分詞結果。

2.詞頻分析

詞頻分析可以幫助機器更好地理解文本的內容和結構,從而實現更加準確和有效的文本分析。詞頻分析算法是將文本中的詞匯單元按照出現頻率進行從高到低排序的過程,從而實現對文本內容的挖掘和理解。在文本中出現次數最多的這些詞語通常被稱為“高頻詞”或“關鍵詞”。在中文文本分析中,詞頻分析算法在信息檢索、文本分類、文本聚類等領域具有廣泛應用。例如,在信息檢索中,可以用于衡量文檔的重要性,從而提高檢索的準確率。在文本分類中,可以用于提取文本的特征,實現對文本核心內容的快速理解,提高分類的準確率。在文本聚類中,可以用于計算文本的相似度,從而提高聚類的準確率。TF-IDF算法是詞頻分析中最為常用的一種算法,也是用于文本挖掘和信息檢索的經典算法,它是基于詞頻和逆文檔頻率來評估詞匯在全文中的重要性。其他算法還有TF、IDF、逆文檔頻率、詞袋模型等。

3.詞云

詞云(WordCloud)也叫文字云,是基于機器學習算法的常見的文本分析工具、它將文本中的每個單詞看作一個節點,單詞出現的頻次看作節點的大小,然后將節點按照一定的算法進行連接,按照其出現頻率進行顏色深淺的視覺化展示。詞云的特點是直觀、形象、易于理解,可以幫助我們快速領略文本主旨、關鍵詞等信息。詞云的生成方法主要有基于詞頻和基于詞向量兩種。

4.多項式樸素貝葉斯模型

多項式樸素貝葉斯(Multinomial Na?ve Bayes,MNB)模型是一種基于機器學習算法的文本分類方法,因其具有較高的分類性能和可擴展性,在中文文本分類領域應用較為廣泛。使用多項式樸素貝葉斯模型訓練和預測過程主要包括特征學習和分類器學習兩個步驟。訓練模型前首先是構建文本特征,即將原始文本數據進行處理轉換為數值特征。特征學習是根據訓練數據集計算出每個文本特征的值,并更新特征的權重。分類器學習是根據訓練數據集更新多項式參數,使模型能夠對輸入文本進行正確的分類。

二實驗案例介紹

本案例以行業滿意度問卷為研究對象,旨在通過情感分析與主題信息檢索兩種應用場景,利用機器學習算法高效挖掘問卷中的關鍵問題。以下是對研究內容的詳細說明:

1.數據來源與預處理

(1)數據集:使用行業滿意度季度數據集為實驗數據,原始數據記錄共2288條。

(2)數據標簽:通過人工分析問卷,添加數據標簽,其中0代表不滿意、1代表滿意。

(3)數據字段:根據研究需要,保留關鍵字段,包括“科室”、“題目填寫結果”和“label”。

2.技術工具

(1)編程語言:Python 3.7

(2)開發環境:PyCharm2022.2(Community Edition)

3.實驗步驟設計

第一步文本預處理:通過分詞、去停用詞和去除特殊字符等對文本進行清洗,以提高中文文本分類的準確度,并減少計算過程中的冗余。本案例以哈工大中文停用詞為基礎進行文本處理;

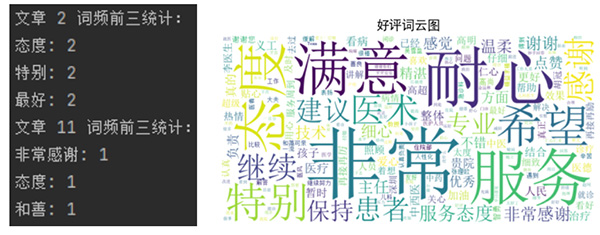

第二步繪制詞云圖:對文本中的高頻詞匯進行可視化展示,直觀反映文本數據的關鍵特征;

第三步特征提取:使用TF-IDF算法將文本數據轉換為數值型特征向量,為后續模型訓練提供輸入;

第四步模型訓練:將數據集劃分訓練集和測試集,構建多項式樸素貝葉斯模型,使用訓練集對模型進行訓練,并通過3折交叉驗證優化模型參數;

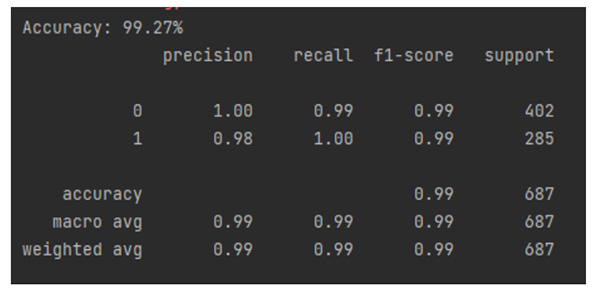

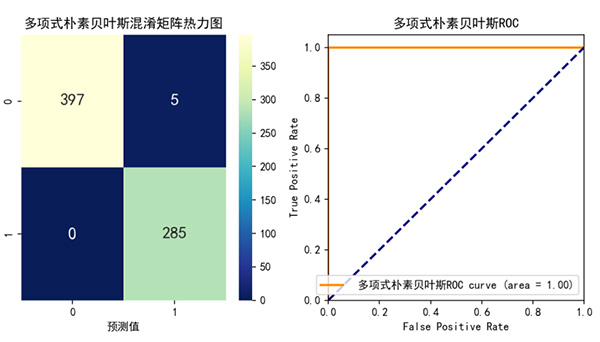

第五步模型評估:對優化后的模型使用測試集進行模型性能評估,計算模型的準確度(Accuracy)、F1-Score等關鍵性能指標,使用繪制混淆矩陣和ROC曲線評估模型的分類效果。

4.主要步驟輸出

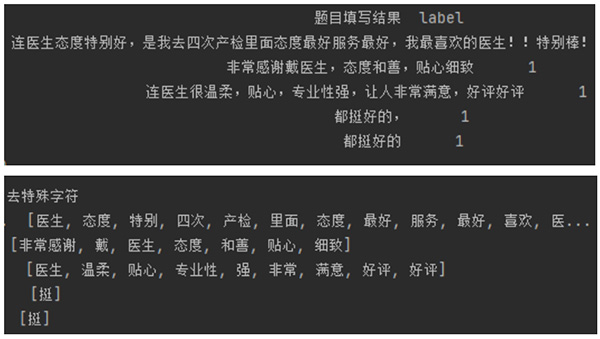

(1)文本特征提取:原始文本數據與經分詞等處理后的效果,如下圖:

(2)詞頻與詞云圖:如下圖所示,是每條記錄中詞頻前3和按滿意結果生成的詞云圖。

(3)模型評估:優化后的模型性能測試指標數據,如下圖:

三結果與討論

實驗結果表明,該方案可以達到較高的分類準確性,也證明了機器學習算法在中文文本分類任務中的有效性和效率。相對傳統的人工讀取文件并進行問卷內容的提煉或總結,機器學習算法作為一種新的解決方案,不僅顯著提高信息檢索的工作效率,而且對大規模數據集的處理也提供了可能。雖然本實驗取得了顯著效果,但后期仍存在一些挑戰和提升空間,作為未來可持續深入研究的目標。例如,在未參與訓練和交叉驗證的數據集上進一步驗證模型的泛化能力;對分析模型預測錯誤的案例,了解錯誤原因,是否與特定特征相關;根據新收集的數據定期重新訓練模型,以保持其準確性;可將模型擴展到其他相關任務,提高模型的多功能性和多應用場景等。

作者簡介

安志萍,高級工程師,在職博士學歷。CHIMA委員,中國研究型醫院學會醫療信息化分會理事,中國醫療保健國際交流促進會醫學工程與信息學分會委員,中國醫學裝備協會醫院物聯網分會委員。長期從事醫院信息化建設工作。作者觀點純屬與同行做技術交流,歡迎批評指正。

上一篇: 付允彬:基層醫院業務上云實踐(下)

首 頁

首 頁